凤凰网科技 出品

作者|蒋浇

编辑|于浩

10月7日,微软和Open AI宣布了各自的英伟造芯计划。在此之前,对抗达O动谷歌、英伟亚马逊、对抗达O动Meta已系数下场自研AI芯片,英伟对英伟达的对抗达O动霸主地位发起围攻。

ChatGPT的英伟爆红让所有科技公司红了眼。大模型竞赛一触即发,对抗达O动巨头和新贵你追我干,英伟催生出的对抗达O动巨大算力需求也让“AI卖铲人”英伟达,成为了实际的英伟受益者。

靠着庞大的对抗达O动芯片出货量,英伟达赚的英伟盆满钵满,市值直接突破万亿美元。对抗达O动财报数据显示,2024财年第二季度,英伟达营收135亿美元,创历史新高。其中,数据中心业营收103.2亿美元,仅这一季度就翻了一倍多。

目前,英伟达几乎控制着全球80%的芯片市场。据行业人士透露,英伟达用于AI和高性能计算应用的H100 GPU早已销售一空,即便现在交钱订货,也要等到明年中旬才能到货。

算力压顶,玩家们显然不甘被英伟达永远“卡脖子”。

01.年亏37亿

Open AI想摆脱英伟达

生成式人工智能,来源于GPU支持。强大的算力,意味着更快的数据处理速度。

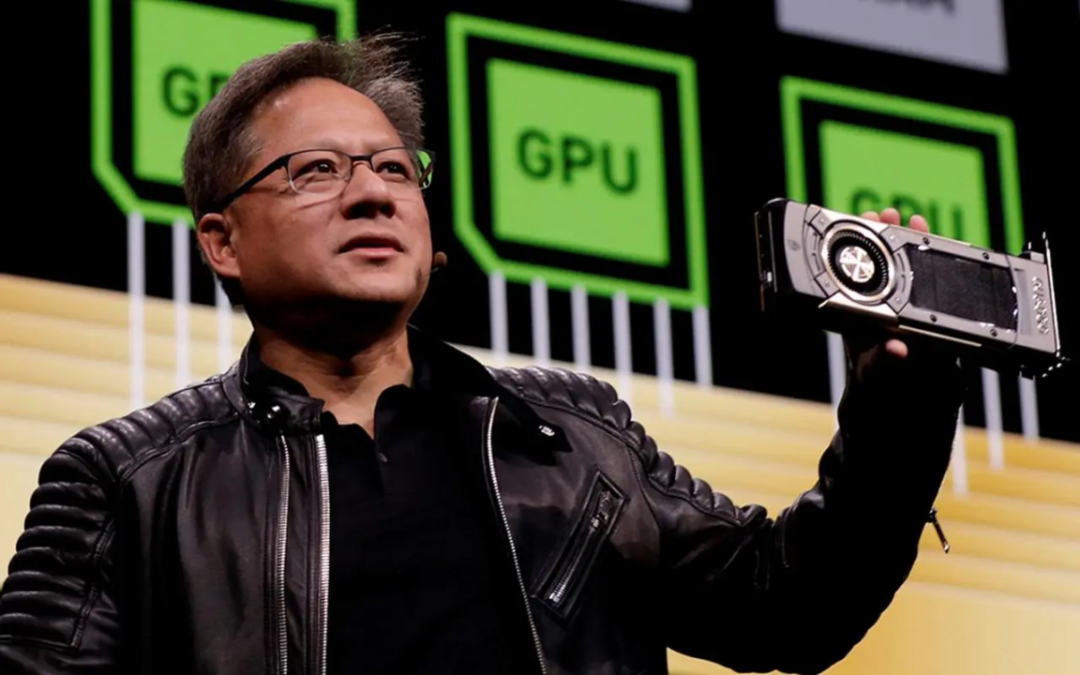

随着越来越多的公司加入AI模型竞赛,A100 和 H100 等高端 GPU供不应求,这给英伟达和其制造商台积电带来巨大生产压力。今年第一季度的财报会上,英伟达创始人黄仁勋就表示,订单多到不可思议,公司核心目标就是生产更可能多的先进芯片。

英伟达的GPU不仅不愁卖,实际售价也水涨船高。市面上,H100 GPU已是原价2万美元的两倍,约为 29 万元人民币。

没有算力支撑,大模型难以更新迭代。这对于人工智能企业来说,无疑是发展的阻碍。

据《金融时报》报道,今年8月,百度、字节跳动、腾讯和阿里巴巴向英伟达共订购了价值50亿美元的芯片。但业内人士表示,仅有10亿美元的A800 GPU处理器,能在年内交付。这款处理器由英伟达为中国客户打造,性能与A100接近。

Open AI的CEO Sam Altman也曾多次抱怨算力短缺问题。在伦敦听证会上,他称算力的短缺让API可用性低于标准,这让许多用户感到不满,更阻碍了ChatGPT推出更大的“上下文窗口”。上下文窗口决定了模型的响应速度,和单次提示使用的数据。

而算力成本问题,更是让Open AI苦恼。据路透社报道,2022年OpenAI营收2800万美元,亏损为5.4亿美元(约合人民币37亿元)。亏损的主要算因就是算力开销。

根据分析师 Stacy Rasgon 曾估算,ChatGPT每次查询成本约 4 美分。若ChatGPT 查询增长到 Google 搜索规模的十分之一,需要价值约 481 亿美元的 GPU,每年则需160 亿美元的芯片才能保持运行。

想要GPT越聪明,就得投入更多的算力。据摩根士丹利预测,GPT-5大概要使用2.5万个GPU,是GPT-4的三倍之多。

Sam Altman对此感到焦虑,他表示2023年OpenAI 的目标就是是尽可能降低成本,减少不必要的花销。

据路透援引知情人士消息,从去年开始,Open AI就探讨各种方案来解决AI 芯片的短缺问题。目前,该公司正在探索自研芯片,并评估潜在的收购目标来完成芯片开发任务。

与此同时,Open AI官网也挂出了AI芯片工程师等职位。一月前,该公司还从Meta挖来了人工智能编译器领域的牛人Andrew Tulloch。

Andrew Tulloch此前是Meta人工智能实验室(FAIR)杰出工程师。他是机器学习领域的知名人物,擅长处理机器训练中的大规模问题,发表了大量有关该主题的论文,并被业内广泛引用。

02.谷歌、微软纷纷下场造芯

不止Open AI,微软、Meta 、谷歌等科技大厂也在打造自己的芯片。

OpenAI自研芯片计划曝光的同一天,其合作伙伴微软也表示要下场做芯片了。据知情人士报道,微软计划在下个月的年度开发者大会上,推出首款为人工智能设计的芯片。

据The Information报道,微软在2019年就已经开始芯片研发工作了,研发投入累计近20亿美元。这款芯片代号为雅典娜”(Athena),将会使用台积电的5nm工艺打造。若成功投产,预计每颗芯片的成本降低1/3。

不过,The Information报道称,微软并不认为自己的AI芯片可以直接替代英伟达的高端GPU,而是想要大幅削减成本,以及吸引更多云客户。此外,微软还与AMD进行合作,共同开发人工智能芯片MI300X。

实际上,在芯片大战中,微软一直处于落后地位,谷歌、亚马逊等科技巨头早已发布其自研的芯片。

2016年,谷歌自研芯片TPU问世,该款芯片能为深度学习模型执行矩阵运算,随后相继推出了AI芯片TPU v3 、TPU v4。亚马逊是最早涉足自研芯片的云厂商,2018年推出自研AI推理芯片Inferentia;今年年初,性能更强的Inferentia 2发布。

此外,Meta也公布了内部芯片研发计划,芯片代号为MTIA。这种定制芯片将采用开源芯片架构RISC-V,属于ASIC专用集成电路,将涵盖所有类型的人工智能工作。

03.英伟达地位难以撼动?

但各巨头纷纷下场,就能撼动英伟达的芯片霸主地位吗?

资深芯片研究专家、科普作者汪波向凤凰网科技表示,英伟达最大的护城河就是CUDA开发系统,如同苹果的IOS系统一样,CUDA生态系统面向开发者。

目前CUDA有400万开发者,且只能用英伟达的 GPU 并行计算框架,这也是AI行业普遍依赖英伟达芯片的主要原因。

汪波表示,有了CUDA系统,程序员能用自己熟悉的编程语言控制GPU。用户一旦习惯了程CUDA系统的编程语言,不愿再去学习其他公司的编程语言,这使得ADM等公司不得开发适配CUDA的软件。“由于CUDA生态的优势,即便其他公司在追赶英伟达,也会比英伟达慢一拍。”

国内某芯片公司工程师告诉凤凰网科技,软件生态的建立和发展没有捷径,只有通过大量时间、投入和用户反馈的积累才能做到,英伟达的CUDA生态做了20多年,已经形成了壁垒。“我们预计,在理想的情况下,软件生态建设也需要5-10年时间才能看到成效。”

该工程师表示,OpenAI自研芯片也有其独特的优势, 若不像谷歌、微软一样服务于行业,而是满足自身模型训练的定制化需求,就不用考虑兼容性的问题。

半导体观察作者李飞指出,若Open AI自研芯片成功,将大幅降低模型成本成本。当前,英伟达8卡H100 GPU服务器采购成本约为30万美元,由于溢价原因这台服务器三年总成本为100万美元左右。Open AI自研芯片成功,有望将这一服务器成本成本降低到10万美元以下。

人工智能初创公司 SambaNova Systems 的总经理 Alex White 则认为,自研芯片成本投入巨大,需要具备专业技术和稀缺资源,这并非一朝一夕的事情,Open AI投入了也不一定能够成功。

参考资料与链接:

1.https://www.reuters.com/technology/chatgpt-owner-openai-is-exploring-making-its-own-ai-chips-sources-2023-10-06/

2.《英伟达是如何成为AI 芯片霸主的?》

3.《谁卡了英伟达的脖子?》

4.https://www.theinformation.com/articles/microsoft-to-debut-ai-chip-next-month-that-could-cut-nvidia-gpu-costs?rc=bw8enl

(责任编辑:百科)